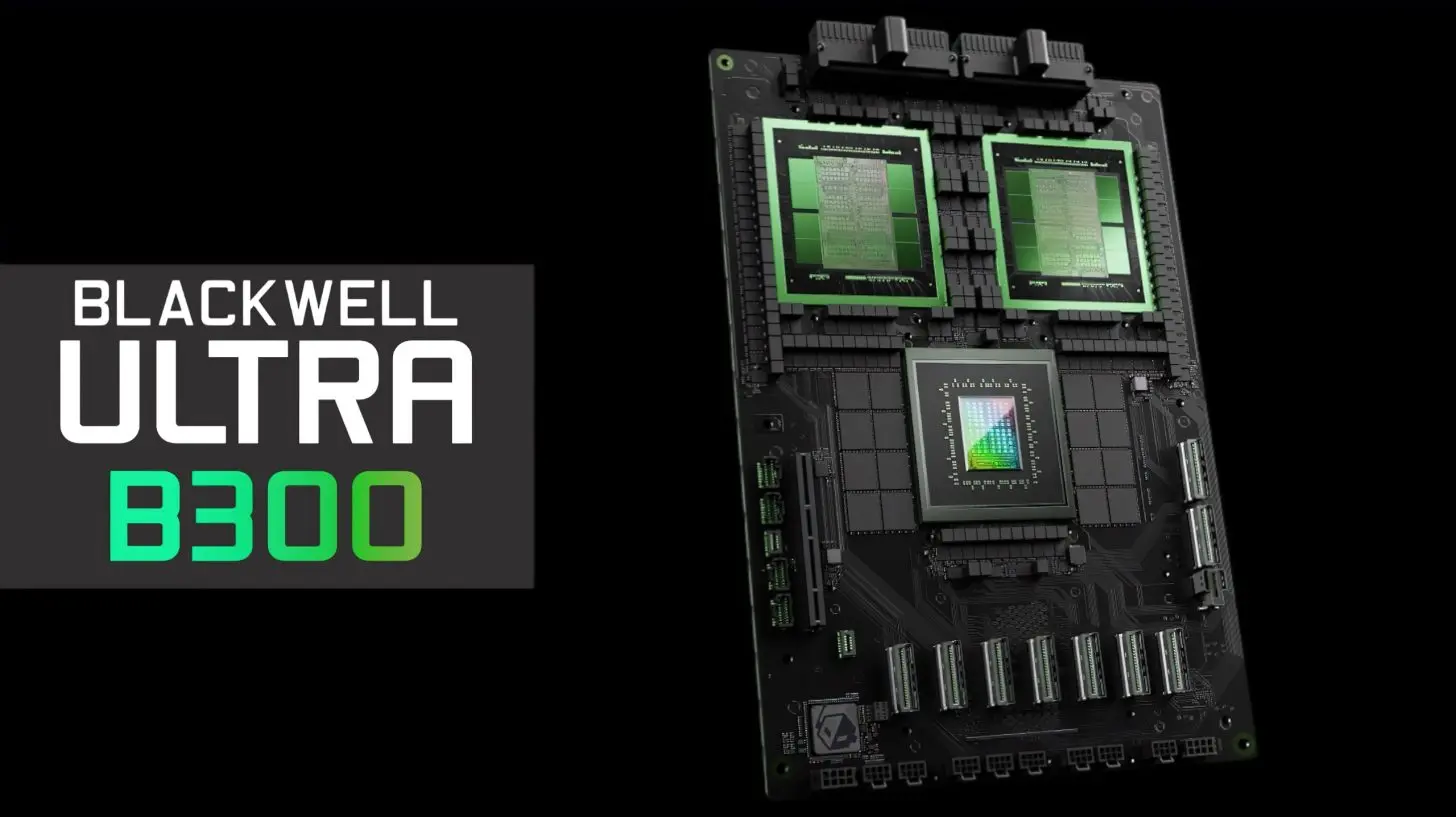

Ngày 3/12, Nvidia giới thiệu máy chủ AI mới nhất với hiệu suất tăng gấp 10 lần so với thế hệ trước, đồng thời được thiết kế tối ưu để xử lý các mô hình AI tiên tiến, đặc biệt là những mô hình theo kiến trúc Mixture-of-Experts (MoE). Đây là bước đột phá quan trọng trong bối cảnh ngành AI chuyển trọng tâm từ huấn luyện sang triển khai rộng rãi các mô hình cho hàng triệu người dùng.

Máy chủ mới của Nvidia được trang bị tới 72 chip AI hàng đầu cùng hệ thống kết nối tốc độ cao giúp nâng cao khả năng xử lý hiệu quả từng phần của mô hình, điều mà kiến trúc MoE tận dụng tối đa bằng cách phân chia nhiệm vụ cho các chuyên gia riêng biệt trong hệ thống. Điều này không chỉ thúc đẩy hiệu suất mà còn giảm thời gian huấn luyện, mang lại lợi thế lớn cho các mô hình AI hiện đại.

Kiến trúc MoE đã trở nên phổ biến rộng rãi trong năm 2025, được nhiều công ty lớn như OpenAI, Mistral hay Moonshot AI áp dụng và phát triển. Đặc biệt, công ty DeepSeek của Trung Quốc đã phát triển mô hình nguồn mở hiệu suất cao dựa trên MoE, sử dụng chip Nvidia để rút ngắn thời gian huấn luyện so với các đối thủ.

Bên cạnh đó, Nvidia vẫn duy trì vị trí dẫn đầu nhờ khả năng tích hợp nhiều chip trong cùng một máy chủ và lợi thế về kết nối tốc độ cao giữa các chip. Tuy nhiên, sự cạnh tranh cũng ngày càng gay gắt với các đối thủ như AMD, dự kiến sẽ ra mắt máy chủ AI tương tự để cạnh tranh trực tiếp trong mảng inference – xử lý và triển khai mô hình AI.

Việc ra mắt máy chủ AI mới mạnh gấp 10 lần cho thấy Nvidia không chỉ khẳng định vị thế hàng đầu trong ngành công nghiệp AI mà còn chuẩn bị cho các cuộc đua quyết liệt, đồng thời đáp ứng nhu cầu gia tăng từ các mô hình AI phức tạp và ứng dụng rộng rãi trên toàn cầu.